2025年自动搜题的脚本怎么做出来的(自动搜题的脚本怎么做出来的呢)

文章摘要

自动搜题的脚本是一种利用编程技术实现自动搜索和解答问题的工具。本文将从六个方面详细阐述如何制作自动搜题的脚本:需求分析、技术选型、数据抓取、问题解析、答案匹配和性能优化。通过这些步骤,读者可以了解从需求到实现的完整过程,掌握制作自动搜题脚本的关键技术。本文旨在为开发者提供实用的指导,帮助他们更好地理解和应用自动搜题技术。

正文

1. 需求分析

在制作自动搜题的脚本之前,首先需要进行详细的需求分析。需求分析的目的是明确脚本的功能和使用场景。例如,脚本是否需要支持多种题型,如选择题、填空题和简答题?是否需要支持多种语言?这些问题都需要在需求分析阶段得到解答。

需求分析还需要考虑用户的需求。例如,用户可能希望脚本能够快速返回答案,或者希望脚本能够提供详细的解题步骤。这些需求将直接影响脚本的设计和实现。

需求分析还需要考虑脚本的扩展性。例如,未来是否可能需要支持更多的题型或更多的搜索引擎?这些因素都需要在需求分析阶段进行考虑。

2. 技术选型

技术选型是制作自动搜题脚本的关键步骤。需要选择合适的编程语言。Python 是一种常用的选择,因为它具有丰富的库和强大的数据处理能力。需要选择合适的框架或库,例如 BeautifulSoup 用于网页抓取,或 TensorFlow 用于机器学习。

接下来,需要选择合适的搜索引擎。不同的搜索引擎可能提供不同的 API 或抓取方式,因此需要根据需求选择最合适的搜索引擎。例如,Google 和 Bing 都提供 API,而百度则需要通过网页抓取的方式获取数据。

还需要考虑数据存储和处理的方式。例如,是否需要使用数据库来存储抓取的数据,或者是否需要使用缓存来提高查询速度。这些技术选型将直接影响脚本的性能和稳定性。

3. 数据抓取

数据抓取是自动搜题脚本的核心功能之一。需要编写爬虫程序,用于从搜索引擎或其他网站抓取数据。爬虫程序需要能够处理各种网页结构,并提取出有用的信息。

数据抓取还需要考虑反爬虫机制。许多网站都有反爬虫机制,例如 IP 封禁或验证码。爬虫程序需要能够应对这些机制,例如使用代理 IP 或自动化验证码识别。

数据抓取还需要考虑数据的清洗和预处理。抓取到的数据可能包含噪声或不完整的信息,因此需要进行清洗和预处理,以确保数据的准确性和完整性。

4. 问题解析

问题解析是自动搜题脚本的另一个核心功能。需要对用户输入的问题进行解析。这可能涉及到自然语言处理(NLP)技术,例如分词、词性标注和句法分析。通过这些技术,可以将用户输入的问题转化为计算机可以理解的形式。

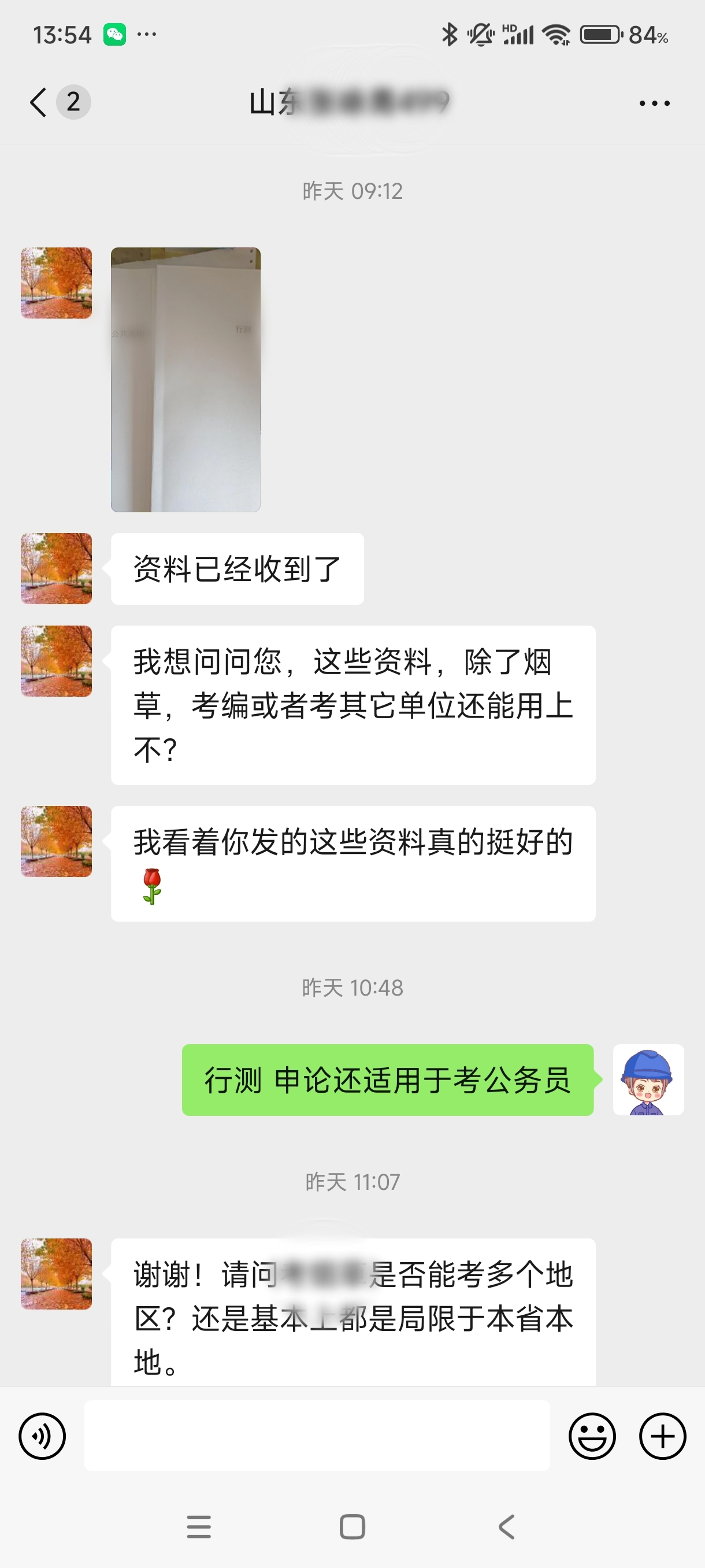

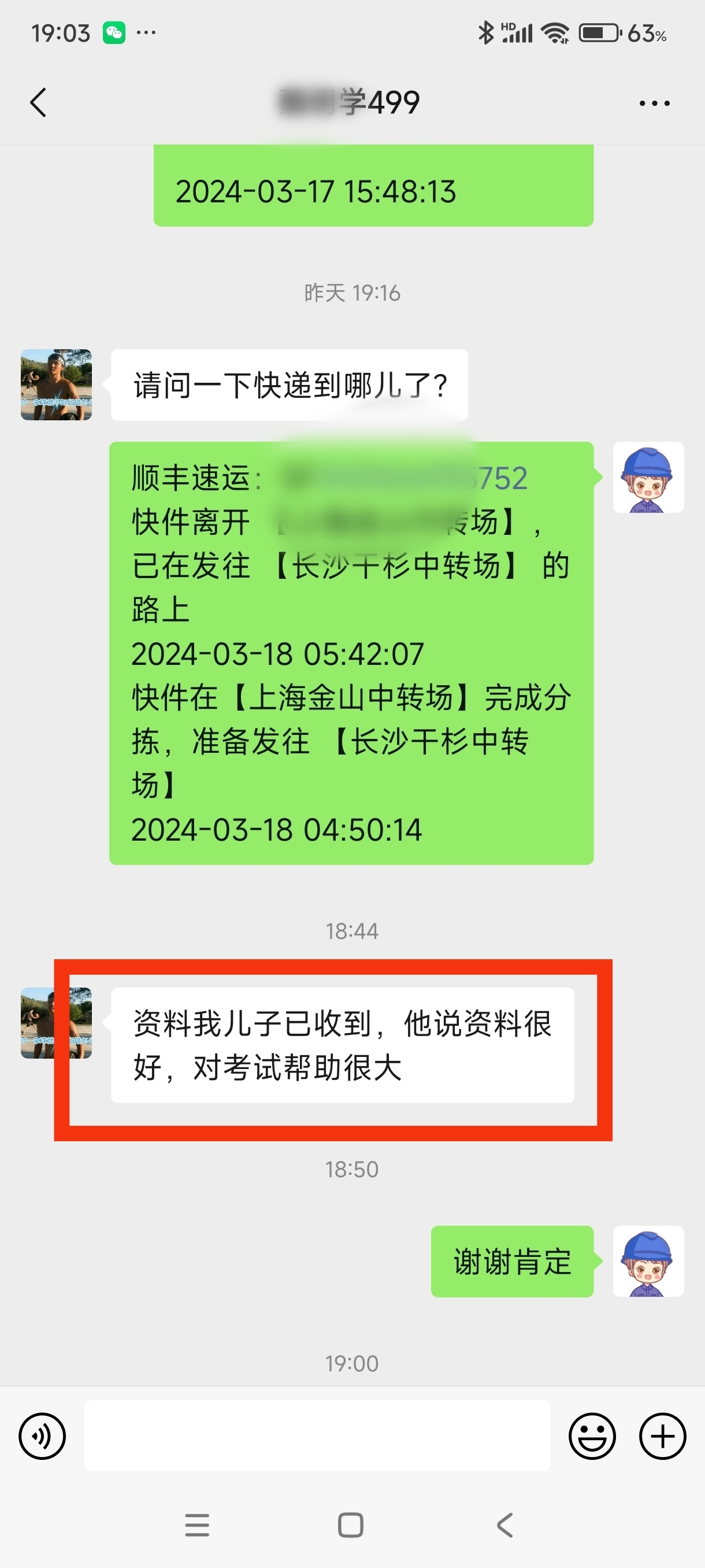

学员评价

推荐阅读:

- 上一篇:2025年适合高中生的搜题软件(适合高中生的搜题软件推荐)

- 下一篇:没有了